Использование сервера ClickHouse MCP с LibreChat

Этот гид объясняет, как установить LibreChat с сервером ClickHouse MCP, используя Docker, и подключить его к примерам наборов данных ClickHouse.

Установка docker

Вам потребуется Docker для запуска LibreChat и сервера MCP. Чтобы получить Docker:

- Посетите docker.com

- Скачайте Docker desktop для вашей операционной системы

- Установите Docker, следуя инструкциям для вашей операционной системы

- Откройте Docker Desktop и убедитесь, что он запущен

Для получения дополнительной информации смотрите документацию Docker.

Клонирование репозитория LibreChat

Откройте терминал (командную строку, терминал или PowerShell) и выполните команду для клонирования репозитория LibreChat:

Создание и редактирование файла .env

Скопируйте файл конфигурации-примера из .env.example в .env:

Откройте файл .env в вашем любимом текстовом редакторе. Вы увидите секции для

многих популярных провайдеров LLM, включая OpenAI, Anthropic, AWS bedrock и т.д., например:

Замените user_provided на ваш API-ключ для выбранного провайдера LLM.

Если у вас нет API-ключа, вы можете использовать локальный LLM, такой как Ollama. Вы увидите, как это сделать позже в шаге "Установить Ollama". Пока что не изменяйте файл .env и продолжайте с следующими шагами.

Создание файла librechat.yaml

Выполните следующую команду, чтобы создать новый файл librechat.yaml:

Это создаст основной файл конфигурации для LibreChat.

Добавление сервера ClickHouse MCP в Docker compose

Далее мы добавим сервер ClickHouse MCP в файл Docker compose LibreChat, чтобы LLM могла взаимодействовать с игровой площадкой SQL ClickHouse.

Создайте файл с именем docker-compose.override.yml и добавьте в него следующую конфигурацию:

Если вы хотите исследовать свои собственные данные, вы можете сделать это, используя хост, имя пользователя и пароль вашей службы ClickHouse Cloud.

Настройка сервера MCP в librechat.yaml

Откройте librechat.yaml и добавьте следующую конфигурацию в конце файла:

Это настраивает LibreChat для подключения к серверу MCP, работающему на Docker.

Найдите следующую строку:

Для простоты мы временно удалим необходимость аутентификации:

Добавление локального LLM с помощью Ollama (по желанию)

Установка Ollama

Перейдите на сайт Ollama и установите Ollama для вашей системы.

После установки вы можете запустить модель следующим образом:

Это загрузит модель на ваш локальный компьютер, если она еще не присутствует.

Для получения списка моделей смотрите библиотеку Ollama

Настройка Ollama в librechat.yaml

После завершения загрузки модели настройте ее в librechat.yaml:

Запуск всех сервисов

Из корневой папки проекта LibreChat выполните следующую команду для запуска сервисов:

Подождите, пока все сервисы полностью запустятся.

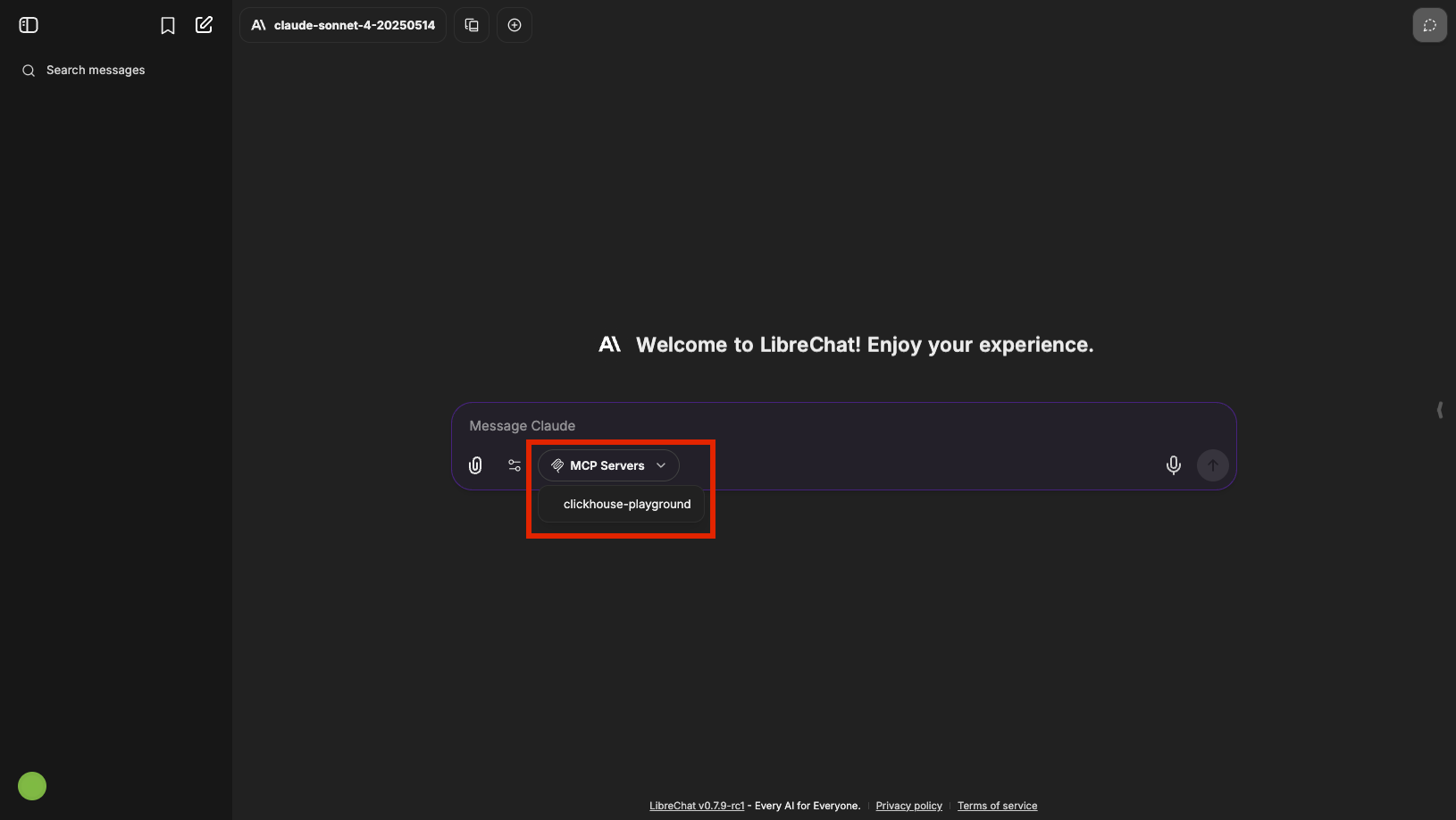

Открытие LibreChat в вашем браузере

Как только все сервисы будут запущены, откройте ваш браузер и перейдите по адресу http://localhost:3080/

Создайте бесплатную учетную запись LibreChat, если у вас ее еще нет, и войдите в систему. Теперь вы должны увидеть интерфейс LibreChat, подключенный к серверу ClickHouse MCP, и, при желании, вашему локальному LLM.

В интерфейсе чата выберите clickhouse-playground в качестве вашего сервера MCP:

Теперь вы можете задавать вопросы LLM, чтобы исследовать примеры наборов данных ClickHouse. Попробуйте: